موتور های جستجوی وب یکی از مهم ترین بخش های زندگی انسان های امروزه را تشکیل میدهد. از مطالعه و سرگرمی تا کسب و کار و معامله همه و همه در بستر اینترنت و با استفاده از موتور های جستجو انجام می شود. به راحتی و در کم ترین زمان می توان پاسخ بسیاری از سوالات را پیدا کرد و یا از فروشگاه های مختلف تجربه خریدی مطمئن را داشت. به راحتی آموزش های مختلف را مشاهده کرد و درباره علاقه مندی ها به بررسی و تحقیق پرداخت.

موتور جستجو وب

هر چیزی که در میان انبوهی از اطلاعات، داده های مشخصی را پیدا کند موتور جستجو نامیده می شود. در فضای وب هر روز اطلاعات جدیدی اضافه می شود و این حجم از داده نیاز به نرم افزاری دارد تا با استفاده از آن بتوان اطلاعات مورد نظر را پیدا کرد. موتور جستجوی وب نرم افزاری تحت وب است که با توجه به درخواست کاربر اطلاعات مرتبط را با توجه به الگوریتم های خاصی دسته بندی کرده و نمایش می دهد.

از پرطرفدار ترین موتور های جستجو وب می توان به گوگل و یاهو اشاره کرد. موتور های جستجو اطلاعات را بر اساس الگوریتم های خاص و با استفاده از ربات ها دسته بندی کرده و دسته هایی با موضوعات مشابه را رتبه بندی می کند. زمانی که کاربر موضوع مشخصی را سرچ می کند، بر اساس دسته بندی و رتبه ی سایت ها، لیستی از صفحات مرتبط با موضوع درخواستی به کاربر نشان داده می شود.

اولین موتور جستجو

نیاز به ابزاری برای دسترسی سریع به اطلاعات مختلف با گسترش شهر ها و رشد جوامع افزایش یافت. بعد از ورود کامپیوتر ها و اتصال آنها به یکدیگر و ایجاد شبکه، امکانی برای ذخیره و فهرست بندی داده ها ضروری بود. آرچی اولین موتور جستجویی بود که در یک پروژه دانشجویی توسط آلان امتیچ در دانشگاه مگ گیل کانادا خلق شد. این موتور جستجو تنها می توانست اطلاعات را از کامپیوتر هایی که به یه یک شبکه متصل بودند دریافت کرده، فهرست بندی کند و با نام مشخصی نمایش دهد.

پیدا کردن داده ها به وسیله آرچی، تنها درصورتی امکان پذیر بود که نام دقیق و مکانی از سرور که داده در آن ذخیره شده است، مشخص شود. بعد از آرچی موتور های جستجو توسعه یافتند و موتور های جستجوی وب مطرح شدند. موتور جستجوی W3 CATALOG اولین موتور جستجوی وب است که در سال 1993 توسط اسکار نیرسترش در دانشگاه ژنو به وجود آمد. امروزه تعداد زیادی از موتور های جستجو با سطح دسترسی های مختلف و امکانات متفاوت در دسترس کاربران قرار گرفته است.

انواع موتور های جستجوی وب

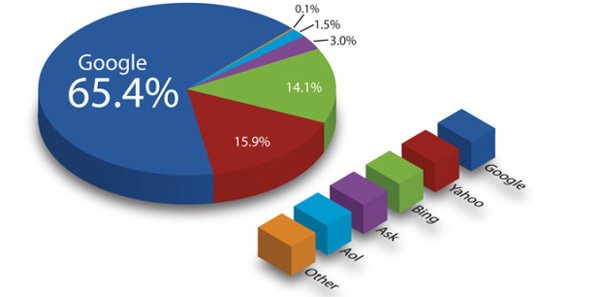

از زمان به وجود آمدن اولین موتور جستجوی وب تا کنون کمپانی های زیادی نرم افزار هایی را برای سهولت جستجو در فضای اینترنت ارائه کردند. از این میان بیشترین سهم متعلق به شرکت گوگل است. موتور جستجوی گوگل که در 15 سپتامبر 1997 راه اندازی شد تا امروز بیشترین تعداد کاربران را از آن خود کرده است.

این نرم افزار پرطرفدار ترین و شناخته شده ترین موتور جستجو در جهان به حساب می آید. دیگر موتور های جستجو و میانگین کاربران هر کدام در نمودار زیر نشان داده شده است:

عملکرد موتور جستجو

موتور های جستجو الگوریتم های مختلفی را برای رتبه دهی به صفحات مختلف اعمال می کنند که به صورت کلی شباهت های زیادی به یکدیگر دارند. به عنوان مثال گوگل با استفاده از ربات ها تعداد کلمات کلیدی، لینک دهی ها، عمق کلیک کاربر، محتوا و … را بررسی می کنند و بر اساس چارچوب های طراحی شده درباره رتبه سایت تصمیم گیری می شود.

بسیاری از این الگوریتم ها و نکاتی که توسط ربات ها بررسی می شوند برای ایجاد یک رقابت منصفانه بین سایت های مختلف نامشخص است. دلیل پنهان بودن این ساز و کار ها این است که راه های دور زدن و تقلب به حداعقل برسد و افراد برای عرضه بهترین محتوا برای کاربران و بازدیدکنندگان تلاش کنند. به علاوه برای ارتقاء رتبه سایت و بهبود عمکلرد موتور های جستجو کارشناسان سئو با بررسی کامل موتور ها و چارچوب های کلی آن کیفیت یک سایت را برای به دست آوردن رتبه اول بهبود می بخشند.

عملکرد موتور های جستجو بر اساس برخی از ساز و کار های فاش شده را می توان به چند دسته تقسیم کرد:

- خزیدن( crawling): ربات های گوگل که از به آنها اصطلاحا “spider” یا عنکبوت گفته می شود با خزیدن و گردش در صفحات مختلف اطلاعات را بررسی میکنند. این ربات ها با بررسی محتوا و کلمات کلیدی مرتبط و با استفاده از لینک های موجود در یک صفحه میان صفحات مختلف یک سایت خزش می کنند.

- ایندکس(indexing): ربات ها با خزش در صفحات مختلف محتوای آن را ایندکس می کنند. ایندکس کردن به معنای ذخیره و مرتب کردن اطلاعات در پایگاه داده است. زمانی سایت در نتایج جستجو دیده خواهد شد که این ربات ها محتوا را ایندکس کرده باشند.

- پردازش: زمانی که کاربر موضوعی را جستجو میکند اطلاعات مرتبط با موضوع که توسط خزنده های گوگل یافت شده و در پایگاه داده فهرست بندی یا ایندکس شده است بر اساس کیفیت سایت و محتوا رتبه بندی شده و در نتایج سرچ به کاربرد نشان داده می شود.

برخی از الگوریتم ها

احتمالا اولین موردی که ربات های خزنده بر روی سایت مورد بررسی قرار می دهند سرعت بارگذاری است. سرعت یک سایت یکی از مهم ترین عواملی است که در رتبه دهی یک صفحه بررسی می شود. اگر سرعت بارگذاری سایت به دلایل مختلف مانند استفاده از عکس و ویدئو هایی با حجم بالا و یا استفاده از هاست با پشتیبانی ضعیف و نامتناسب با عملکرد سایت پایین باشد، امتیازی منفی از نظر ربات های جستجو خواهد بود.

آمار ها نشان می دهد که کاربران برای بارگذاری یک صفحه وب بیشتر از 3 ثانیه منتظر نمی مانند. عدم ورود بازدیدکننده به سایت و کاهش کلیک از دیگر مواردی است که توسط ربات ها بررسی می شود. بالا بودن ترافیک سایت و آمار بازدید ها علاوه بر افزایش بازدهی برای کسب و کار ها باعث ارتقاء رتبه سایت می شود.

موارد دیگری مانند کیفیت محتوا و یونیک بودن آن، لینک دهی های داخلی و خارجی، آدرس سایت (site map)، پراکندگی کلمات کلیدی، عمق کلیک و… از جمله موضوعاتی است که توسط ربات های موتور های جستجو بررسی می شوند. بسیاری از الگوریتم ها همانطور که گفته شد توسط کمپانی های موتور های جستجو فاش نمی شود. در ادامه به اختصار برخی از الگوریتم های شناخته شده گوگل را شرح می دهیم.

- فِرِد: بررسی سایت هایی با محتوای کم و تبلیغات زیاد

- پوزوم: دسته بندی و نمایش نتایج بر اساس موقعیت مکانی کاربر

- رنک برین: درک معنایی سوالات سرچ شده و نمایش بهترین و مرتبط ترین نتایج به کاربر

- فهرست بندی برای موبایل: بررسی رسپانسیو بودن سایت و صفحات مختلف و نمایش صحیح در دیگر دستگاه ها

- کبوتر: سوالاتی که مربوط به موقعیت مکانی باشد را دسته بندی کرده و نزدیک ترین نتیجه به مکان کاربر را نمایش می دهد.

- مرغ مگس خوار: فهرست بندی معنایی محتوا و نمایش بهترین نتایج به کاربر. حتی اگر کلمه کلیدی در متن موجود نباشد

- پاندا: بررسی متن و اصالت محتوا، تعداد کلمات کلیدی و منحصر به فرد بودن صفحه

- پنگوئن: بررسی بک لینک های خریداری شده و عدم وجود تکنیک های کلاه سیاه

- برت: تطبیق زبان محاوره سرچ شده توسط کاربر با زبان ماشین برای درک و تحلیل بهتر و نمایش محتوای نزدیک تر

- تازگی محتوا: بررسی وضعیت بروزرسانی در سایت

- رقص گوگل: بررسی میزان رضایت مندی بازدیدکنندگان از یک سایت و رتبه دهی بر این اساس

- سند باکس: برای رتبه دهی هرچه بهتر، سایت های قدیمی و معتبر از سایت های تازه تاسیس جدا میشوند. سایت های جدید بعد از چند ماه فعالیت و تولید محتوا، رتبه بندی می شوند. دلیل این وقفه کاهش امکان فریب برای دستیابی به رتبه بالا است.

در پایان

همانطور که گفته شد موتور های جستجوی وب از مهم ترین ابزار های دنیای امروز به شمار می روند. کسب و کارها با پیشرفت تکنولوژی و دسترسی راحت و استفاده همگانی از فضای اینترنت و موتور های جستجو دچار تغییر شده اند. با وجود پلتفرم ها و بستر هایی به جز سایت ها برای راه اندازی یک کسب و کار، مانند شبکه های اجتماعی، همچنان سایت ها به دلیل اعتماد سازی برای مشتریان طرفداران زیادی دارند.

محتوای آموزشی و سرگرمی، کتابخانه های الکترونیکی، امکان دانلود نرم افزار های کاربردی، انتقال وجه و کارهای بانکی، پرداخت قبوض و بسیاری دیگر از فعالیت هایی که روزانه با آن سر و کار داریم در بستر اینترنت و با استفاده از موتور های جستجو در کم ترین زمان انجام می شوند.

برای کسب اطلاعات بیشتر از محصولات شرکت نرم افزاری بهاران سیستم کلیک کنید

بدون دیدگاه